|

虽然人工智能正给人类生活带来翻天覆地的变化,但是,很多人并未考虑到人工智能也存在诸多安全隐患,尤其是其核心的深度学习技术更是面临着众多潜在威胁。随着深度学习应用越来越广泛,越来越多的安全问题也开始暴露出来。

日前,360安全研究院结合过去一年对深度学习系统安全性的详细研究,出具了《AI安全风险白皮书》,白皮书指出:深度学习框架中的软件实现漏洞、对抗机器学习的恶意样本生成、训练数据的污染等可能导致人工智能所驱动的识别系统出现混乱,形成漏判或者误判,甚至导致系统崩溃或被劫持,并可以使智能设备变成僵尸攻击工具。

图1:谷歌AlphaGo围棋功力惊艳全球

近年来,以谷歌AlphaGo为代表的人工智能技术惊艳了世人眼球。大家都为人工智能高超的运算能力和缜密的逻辑判断所惊呆。不过,一个事实却是:AlphaGo的深度学习技术只是在封闭的环境下工作,并不与外界直接交互,因此它面临的安全威胁相对较小。此外,其他受到关注的应用往往假定处于善意的或封闭的场景,例如高准确率的语音识别中的输入都是自然采集而成,图片识别中的输入也都来自正常拍摄的照片,这些讨论没有考虑认为恶意构造或合成的场景。

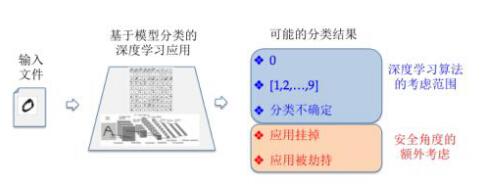

以人工智能中最典型的手写数字识别为例:基于MNIST数据集的手写数字识别应用是深度学习的一个非常典型例子,其算法层所讨论的分类结果只关心特定类别的近似度和置信概率区间,没有考虑输入会导致程序崩溃甚至被攻击者劫持控制流。这其中被忽略掉的输出结果反映出算法和实现上考虑问题的差距,也就是所谓的人工智能安全盲点。

图2:深度学习算法与安全所考虑的不同输出场景

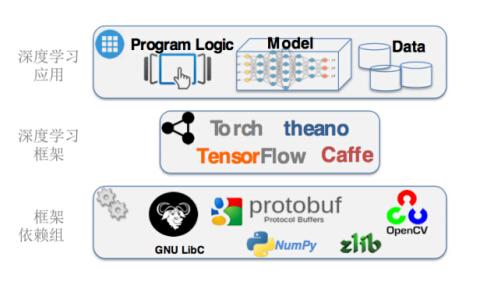

目前,已开发的深度学习软件基本都实现在深度学习框架上。应用开发人员可直接在框架上构建自己的神经元网络模型,并利用框架提供的接口对模型进行训练。但是,这种框架虽然简化了深度学习应用的设计和开发难度,但是也因为系统的复杂程度而暗藏风险。

一个颇为尴尬的事实就是,只要深度学习框架以及它所依赖的任一组件存在漏洞,建立在框架上的应用系统也会随之遭到威胁。另外模块往往来自不同的开发者,对模块间的接口经常有不同的理解。当这种不一致导致安全问题时,模块开发者甚至会认为是其他模块调用不合规范而不是自己的问题。

图3:深度学习框架以及框架组件依赖

为了掌握深度学习软件存在的安全隐患,360 Team Seri0us 团队在一个月内发现了数十个深度学习框架及其依赖库中的软件漏洞,包含了几乎所有常见的漏洞类型,例如内存访问越界,空指针引用,整数溢出,除零异常等。这些漏洞一旦被不法分子利用,就可能导致深度学习应用面临拒绝服务、控制流挟持、分类逃逸以及潜在的数据污染攻击等风险。

因此,在推进人工智能技术应用的同时,我们更要着眼于解决其中存在的安全隐患,使技术更好地为人类的服务。作为国内最大的互联网安全公司,未来360将致力于帮助行业及厂商解决人工智能的安全问题,提升整个人工智能行业的安全系数。

|

提升卡

提升卡 置顶卡

置顶卡 沉默卡

沉默卡 喧嚣卡

喧嚣卡 变色卡

变色卡 千斤顶

千斤顶 显身卡

显身卡